Was sind Deep Fakes?

Deep Fakes, der Begriff geistert immer häufiger durch die Medien. Durch Nutzung künstlicher Intelligenz lassen sich z.B. Videos derart realistisch manipulieren, dass der Betrachter den Eindruck erlangt, dass er tatsächlich Putin beim Sporteln im engen Höschen zuschaut. Was zunächst lustig klingt, kann drastische Folgen nach sich ziehen. Fälschungen mit böser Absicht erstellt, können einen Ruf ruinieren oder Wahlen entscheiden. Und vor dem Hintergrund des aktuellen Krieges möchte man an ein schlimmeres Szenario nicht denken. Woran man aber immer denken sollte: Videos und Bilder kritisch zu hinterfragen. Gar nicht so einfach. Wie enttarnt man aber Deep Fakes und wie können wir uns künftig schützen?

Deep Fakes: Alter Gag neu gedacht

Wir kennen es aus Kindertagen, der Freund oder Feind hat uns geärgert und aus Rache wurde der Kopf ausgeschnitten und auf einem Körper in peinlicher Pose montiert. Kein freundlicher Akt, aber einer der leicht zu durchschauen war. Es wurde gelacht, vielleicht weiter gestritten, aber die Collage konnte kaum für real gehalten werden. Deep Fakes sind weitaus professioneller und gut gemacht, auch von Erwachsenen schwer als Fälschung zu erkennen.

Was sind Deep Fakes?

Der Begriff Deep Fake setzt sich aus den zwei Begriffen „Deep Learning“ (einer Methode des Maschinellen Lernens) und „Fake“ zusammen. Er bezeichnet das Verändern und Verfälschen von Medieninhalten unter Nutzung künstlicher Intelligenz (KI). Es wird dazu auf künstliche neuronale Netze zurückgegriffen, die unstrukturierte Daten wie z.B. ein Bild verarbeiten können. Die Fälschungen lassen sich somit weitgehend autonom auch von Laien erstellen – und das mit qualitativ hochwertigem Ergebnis.

Welche Arten von Deep Fakes gibt es?

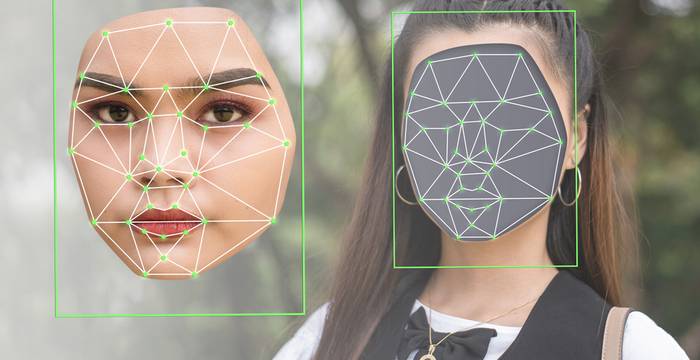

Die bisher bekannteste Art von Deep Fake ist das „Face Swapping“. In visuellem Material, z.B. in einem Video, wird das Gesicht einer Person durch ein anderes getauscht. Die Zielperson wird damit in einen bestimmten Kontext gestellt, in dem sie üblicherweise nicht zu finden ist. Analog dazu wird beim „Voice Swapping“ der Audioinhalt verändert, so dass einer Person Texte und/oder Stimmen in den Mund gelegt werden. Eine weitere Art der Manipulation ist das „Body Puppetry“. Hierbei werden Körperbewegungen auf eine Person übertragen. Diese Form des Deep Fake gilt als die Komplizierteste, da die KI die Umsetzung trainieren muss. Face oder Voice Swapping funktionieren in Echtzeit.

Wer kann Deep Fakes erstellen?

Auch ein Laie ohne Expertenwissen kann mittlerweile unkompliziert täuschend echte Deep Fakes erstellen. Im Internet stehen zahlreiche Tools für Computer sowie Handy zum Download zur Verfügung. Ein Klick und die App lädt zum Vertauschen von Gesichtern oder Stimmen ein. Die Rechenleistung der Technik nimmt zu und KI wird immer leistungsfähiger. Erstellte Deep Fakes werden somit immer authentischer und sind damit immer schwerer als künstlich erzeugtes bzw. verändertes Material zu entlarven.

Missbrauchspotenzial mit Folgen

Manipulierte Medien werden unterschiedlich genutzt, zum einen für Satire und Spaß. Ernst wird es, wenn sie gezielt zur Verbreitung falscher Informationen oder Diskreditierung von Personen eingesetzt werden. Mit böswilliger Absicht erzeugte Inhalte haben großes, zerstörerisches Potenzial. Der größte Schaden wurde bisher im Bereich der Pornografie erzeugt. Ende 2017 wurden mehrere Fake-Pornos mit Schauspielerinnen wie Emma Watson und Scarlett Johansson online gestellt. In kurzer Zeit hatte der Kanal nahezu 100.000 Nutzer und wurde erst nach vier Monaten gesperrt. Schätzungen zufolge sind über 95 Prozent der im Internet verbreiteten Deep Fakes Pornos. Dabei trifft es aber nicht nur Stars. Auch die australische, 17-jährige Schülerin Noelle Martin wurde Opfer der Fake-Pornografie. Da Täter und Webseitenbetreiber von überall agieren können, ist eine Strafverfolgung schwierig und die Gesetzeslage verworren. Noelle Martin ging an die Öffentlichkeit und hat dazu beigetragen, dass Fake-Pornografie in Australien mittlerweile mit bis zu sieben Jahren Gefängnis bestraft werden kann.

Nicht jeder Schaden kann begrenzt werden

Auch wenn es gelingen sollte, die Täter zur Verantwortung zu ziehen, lässt sich nicht jeder Schaden aufheben. Ein ruinierter Ruf lässt sich z.B. nur schwer wieder herstellen. Je authentischer bzw. eindrucksvoller das Bildmaterial desto eher bleibt es in Köpfen hängen. Unabhängig von realen Tatsachen. So wird einem unangenehmen Chef, der bei einem vermeintlichen Betrug der Ehefrau gezeigt wurde, ein gewisses Image anhaften bleiben. Neben dem Schicksal von Einzelpersonen kann ein Deep Fake aber auch die ganze Gesellschaft treffen. Besonders der politische Bereich ist brisant. So können visuelle Fälschungen zur Manipulation der öffentlichen Meinung genutzt werden. Eine Desinformationskampagne begleitet von entsprechenden Deep Fakes wirkt weitaus stärker. Das Gefahrenpotenzial wird durch die schnelle Verbreitung über die Sozialen Medien noch erhöht. Nehmen wir an der Deep Fake ist von sehr guter Qualität und die Quelle wird als glaubwürdig erachtet. Es könnte der Moment kommen, in dem es bis zu einer Enttarnung schon zu spät ist und eine Hysterie Tote nach sich zieht, … wenn nicht den ersten Schritt zu einem Krieg. Natürlich provokant gedacht, aber total unrealistisch? Im Folgenden Video geht Harald Lesch im ZDF Wissenschaftsmagazin „Leschs Kosmos“ auf die Gefahren von Deep Fakes ein:

Wie kann man den Deep Fakes gegensteuern?

Die Erstellung von Deep Fakes ist grundsätzlich nicht illegal. Es sei denn es liegt ein Verstoß gegen das allgemeine Persönlichkeitsrecht, das Urheberrecht oder das Recht am eigenen Bild vor. Je nach Schwere kann dies bis zu einer strafrechtlichen Verfolgung mit Gefängnistrafen führen. Zunächst ist es essenziell, die Deep Fakes als solche zu erkennen und ihnen damit Macht zu rauben. Unter diesem Aspekt wird die Erlangung von Digital- und Medienkompetenz für die heutige Gesellschaft immer wichtiger. Sie können einen gewissen Schutz vor den digitalen Gefahren bieten. Auch wenn das Opfer den Schaden teils weiter mit sich trägt, kann es zumindest Schritte zur Begrenzung einleiten und angemessene Strafe einfordern.

So werden Fälschungen entlarvt

Es wird fleißig an Methoden geforscht, um Deep Fakes zu enttarnen, so z.B. von Prof. Dr. Matthias Niessner an der TU München. Dazu wird ebenfalls KI eingesetzt. Eine Software wird dabei anhand von Fake-Videos trainiert. Sie sucht nach Anhaltspunkten im Bild, die dem menschlichen Auge verborgen bleiben. Prof. Dr. Niessner betont jedoch, dass die KI menschliche Experten bei der Echtheitsanalyse von Medieninhalten nicht ersetzen kann. Sie sei nur ein Tool unter mehreren. Den Ernst des Themas im Blick hat sich auch die Bundesregierung den Deep Fakes angenommen und bearbeitet sie ressortübergreifend. Das Bundesministerium für Bildung und Forschung kümmert sich um die Förderung entsprechender Projekte. So entwickeln Wissenschaftler z.B. Programme, die auf der Basis von KI die Echtheit von Videos und Audioinhalten überprüfen.

Digital- und Medienkompetenz als Gegengift

Was bleibt aber dem Bürger zu Hause, der ebenso wenig Interesse daran hat, auf ein Deep Fake reinzufallen? Intuition alleine reicht hier nicht aus. Der Mensch ist eben menschlich und blendet gerne aus was ihm keinen Nutzen verspricht. Dies geschieht unbewusst. Bösewichte wissen darum und können uns daher um so besser manipulieren. Daher ist es – besonders in der heutigen Welt mit ständiger Reiz- bzw. Informationsüberflutung – wichtig, kritisch zu hinterfragen. Wo kommt das Video her, scheint der Inhalt plausibel etc.? Die zielgruppengerechte Vermittlung von Digitalkompetenzen ist daher zur Kernaufgabe für die Bundesregierung geworden. Dazu gehört auch die Stärkung der Medienkompetenz.

Was kann ich als Opfer von Deep Fakes tun?

Als Opfer eines Deep Fake kann man verschiedene Ansätze verfolgen. Zum einen ist die weitere Verbreitung zu unterbinden. Dabei kann man sich u.a. auf die DSGVO oder den Schutz der persönlichen und beruflichen Ehre berufen. Zum anderen ist zu entscheiden, ob man Klage einreichen möchte. Ein Ruf-Schaden mag bereits erfolgt sein, aber eine Strafe könnte dem Täter eine Lehre sein. Zudem wird ein „Zeichen“ für die Folgen aus dem unsachgemäßen Gebrauch von Deep Fakes gesetzt.

Fake oder real?

Wie schwer es ist, ein Fake-Video von der Realität zu unterscheiden, zeigt eine aktuelle Aufnahme von Putin bei dem Besuch einer Flugschule. An einer Stelle scheint es, als würde er durch das Mikrofon greifen. Als Beweis für eine Fälschungsaktion der russischen Regierung erachtet, geht dies prompt viral. Unter anderem berichtete der Stern darüber. Der Fake-Vorwurf ist nachvollziehbar. Es macht stutzig, dass sich Putin auf einmal sehr nah an den Stewardessen präsentiert. In den vergangenen Wochen war er nur mit großem Abstand zu anderen Personen zu sehen. Annahme: Putin wurde nachträglich in den Hintergrund mit den Damen retuschiert. Wenn man sich den Clip jedoch in der HD-Version mit höherer Auflösung ansieht, bleibt das Mikrofon klar im Vordergrund – kein Durchwischen mehr. Es gibt in dem Fall eine einfache Erklärung für den Effekt der „Geisterhand“. Bei der Komprimierung eines Videos wird eine Version mit weniger Bildpunkten erstellt. Das heißt, der Algorithmus entscheidet welche Pixel zusammengefasst werden. Dies wurde bei dem viralen Clip zum Verhängnis. Pixel des Mikros wurden mit denen aus der Hand vermischt, und so entsteht der falsche Eindruck eines Fake-Videos.

Deutsche Wissenschaftler lassen Putin lächeln

Es muss sich nicht um Deep Fakes handeln. Es gibt noch mehr Arten die Wahrheit zu manipulieren. Deutsche Wissenschaftler, darunter auch Prof. Dr. Niessner, haben bereits 2016 eine Software erstellt, die jedes Gesicht in jedem Video manipulieren kann, und das ohne den Gebrauch von 3-D-Kameras. Sie benötigten dazu nur Youtube, eine Webcam und 15 Sekunden aus einem Video, in dem das Zielobjekt eine Bandbreite an Mimik zeigt. Von diesem Video wird dann ein sofortiges 3-D-Modell generiert. Wenn man die Bewegungen einer anderen Person auf dieses Modell abbildet, erhält man z.B. einen sprechenden Trump oder Putin. Wenn das ursprüngliche Modell in der Sequenz nicht sehr ausdrucksstark war oder es generell nicht ist, kann dies etwas seltsam aussehen. Putin ist hier ein interessantes Beispiel. Man sieht ihn nie lächeln. Über die Software kann man ihn lächeln lassen. Hätte man eine Sequenz mit „seinem“ Lächeln, würde es mehr nach ihm selber aussehen – so ist ihm die Mimik des Manipulators quasi „ins Gesicht geklebt“. Eigentlicher Hintergrund der deutschen Forschung: Verbesserung der Fremdsprachensynchronisation von Filmen sowie Vorteile bei der Live-Video-Chat-Übersetzung. Zudem hoffte das Team aber auch, dass ihre Arbeit verdeutlicht wie leicht es ist Videos zu fälschen und wie echt das aussehen kann. Im Folgenden Video bekommen Sie einen Eindruck der Arbeit:

Auch Interessant:

12. November 2025

Veo 3.1 in der Praxis: Wenn ein Cowboy am Fastnachtsbrunnen parkt

Was passiert, wenn man einen Cowboy mit Sporen,…

29. April 2025

Short-Form vs. Long-Form Video: Welches Format bringt 2025 den größten Erfolg im Marketing?

Video ist längst das dominante Medium im…

3. Mai 2024

ALDI SÜD feiert die Eltern in seiner jüngsten Kampagne “Liebe geht durch den Magen und noch viel weiter…”

Die neue Social Media-Kampagne von Aldi Süd zum…

9. Oktober 2023

Video Seeding ist für Ihr Unternehmen wichtig! Warum nur?

Video Seeding bedeutet übersetzt „Aussaat“. In…